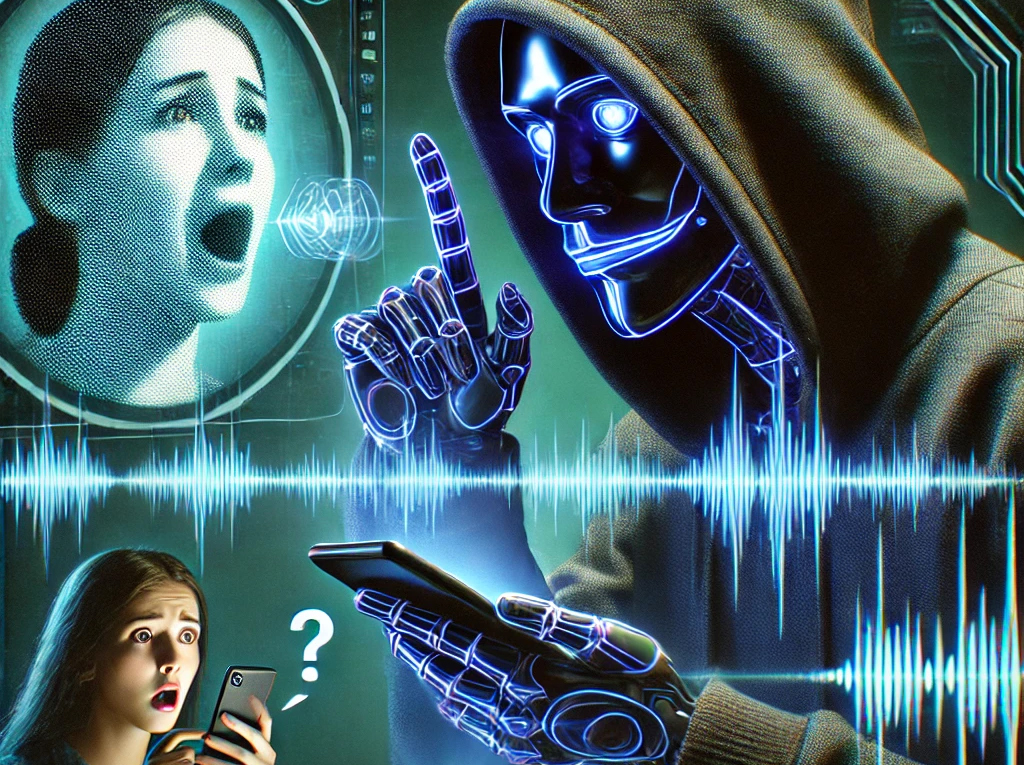

La Inteligencia Artificial (IA) ha revolucionado múltiples industrias, pero también ha abierto nuevas oportunidades para el fraude y la delincuencia cibernética. Uno de los ataques más sofisticados y preocupantes en la actualidad es la clonación de voz con IA, una técnica que permite a los estafadores imitar con precisión la voz de cualquier persona para engañar a familiares, empleados y directivos de empresas.

¿Cómo funciona la clonación de voz con IA?

Gracias a los avances en el aprendizaje automático y la síntesis de voz, los atacantes pueden entrenar modelos de IA con apenas unos segundos de grabaciones de audio de su víctima. Existen herramientas accesibles que permiten replicar el tono, el timbre y hasta las emociones de una persona con una precisión alarmante.

El proceso suele involucrar:

- Recolección de muestras de voz: Los estafadores obtienen grabaciones a partir de llamadas telefónicas, redes sociales, entrevistas o videos en línea.

- Procesamiento con IA: Utilizan modelos de síntesis de voz avanzados para analizar y replicar la voz de la víctima.

- Ejecución del fraude: Mediante llamadas o mensajes de voz falsificados, engañan a las víctimas haciéndose pasar por alguien de confianza.

Casos reales y modalidades de fraude

Los ataques que utilizan clonación de voz con IA han aumentado exponencialmente, afectando tanto a individuos como a empresas. Algunas de las modalidades más comunes incluyen:

Fraude financiero corporativo

Un caso emblemático ocurrió cuando un CEO recibió una llamada de su supuesto superior exigiendo una transferencia urgente de fondos. La voz clonada era tan convincente que la empresa perdió cientos de miles de dólares antes de detectar el engaño.

Secuestros virtuales

Los delincuentes envían mensajes de voz clonados a familiares, haciéndoles creer que un ser querido ha sido secuestrado. El pánico generado hace que las víctimas transfieran dinero sin verificar la situación real.

Suplantación de identidad en redes sociales

Los atacantes utilizan la clonación de voz para reforzar estafas de phishing o deepfakes en redes sociales, haciendo que las víctimas confíen en audios manipulados que parecen provenir de personas cercanas.

Cómo protegerse de estos ataques

Dado que la clonación de voz con IA es una amenaza emergente, es crucial adoptar estrategias de defensa efectivas:

Implementar códigos de verificación

Las empresas deben establecer palabras clave o preguntas secretas para confirmar identidades en llamadas sensibles.

Educar sobre la amenaza

Concienciar a empleados y ciudadanos sobre este tipo de fraudes puede reducir el impacto de las estafas.

Verificar siempre la autenticidad

Ante solicitudes inusuales de dinero o información, es recomendable confirmar la identidad de la persona mediante un canal diferente, como videollamada o contacto en persona.

Uso de tecnología anti-spoofing

Herramientas de detección de IA pueden analizar patrones en la voz clonada para identificar fraudes antes de que causen daño.

La clonación de voz con IA representa un desafío creciente en el ámbito de la ciberseguridad. Tanto individuos como organizaciones deben mantenerse informados y adoptar medidas de protección para no caer en estas sofisticadas estafas. En un mundo donde la tecnología avanza a pasos agigantados, la prevención y la verificación serán nuestras mejores defensas.